NVIDIA H100, H200, AMD MI300X는 모두 고성능 컴퓨팅(HPC)과 AI/ML 워크로드를 타겟으로 하는 최신 GPU입니다.

지금까지 엔비디아 GPU가 AI 분야에서 매우 선호되고 있는 현상과 달리, 최종 선택은 대상 워크로드와 도입목적에 따라 달라지며,

NVIDIA는 AI 중심 응용 프로그램에서 강세를 보이고, AMD는 메모리 집약적이고 이기종 컴퓨팅 시나리오에서 두각을 나타냅니다.

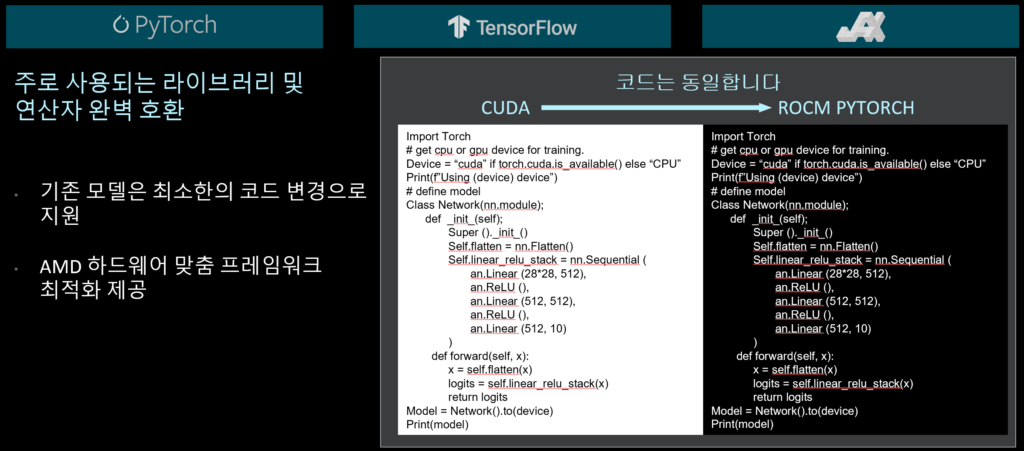

기존 NVIDIA 어플리케이션과의 호환성은 AMD가 약 98% 정도 수준에 도달해 있으며, 약간의 코드 포팅작업은 요구됩니다.

1. 아키텍처

- NVIDIA H100 및 H200:

- H100은 NVIDIA Hopper 아키텍처 기반으로, H200은 AI 및 대형 언어 모델(LLM) 작업을 위해 더욱 최적화된 개선판입니다.

- Hopper는 AI/ML 작업에 중요한 트랜스포머 모델에 최적화된 텐서 코어를 특징으로 합니다.

- H200은 H100에 비해 메모리 대역폭과 계산 효율성이 더욱 향상되었습니다.

- AMD MI300X:

- MI300X는 AMD의 CDNA 3 아키텍처를 기반으로 하며, GPU와 CPU가 통합된 APU(Accelerated Processing Unit)입니다.

- 전통적인 GPU 아키텍처와 달리 MI300X는 HBM(고대역폭 메모리)이 칩에 직접 통합되어 대형 AI 모델을 효율적으로 처리합니다.

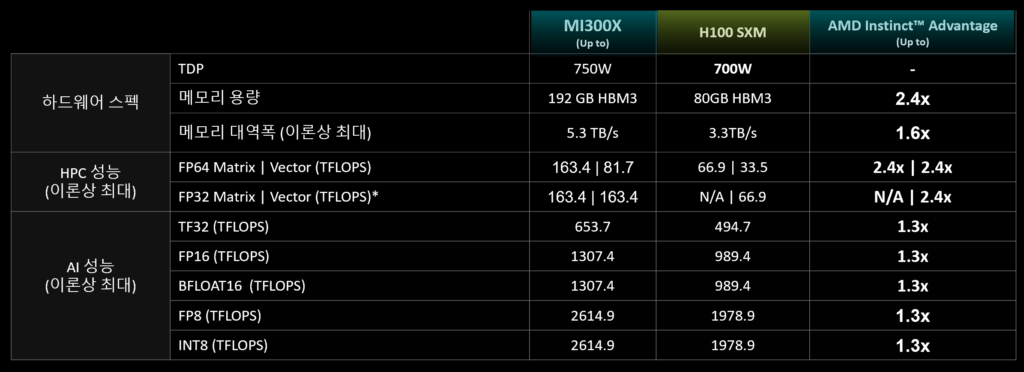

2. 성능 및 연산 능력

- NVIDIA H100:

- FP64 성능: 약 60 TFLOPS(PCIe) / 약 67 TFLOPS(SXM)

- FP16 성능: 약 1,000 TFLOPS

- AI 추론 및 학습에 최적화되어 있으며, AI 작업을 위한 강력한 텐서 코어를 특징으로 합니다.

- NVIDIA H200:

- H100과 기본적으로 같은 사양이며, GPU당 메모리 용량이 약 141GB로 증가되었습니다.

- AMD MI300X:

- FP16 성능: 약 1,000 TFLOPS (H100과 유사)

- MI300X는 특히 AI 모델, 특히 생성형 AI의 확장성에 중점을 둡니다.

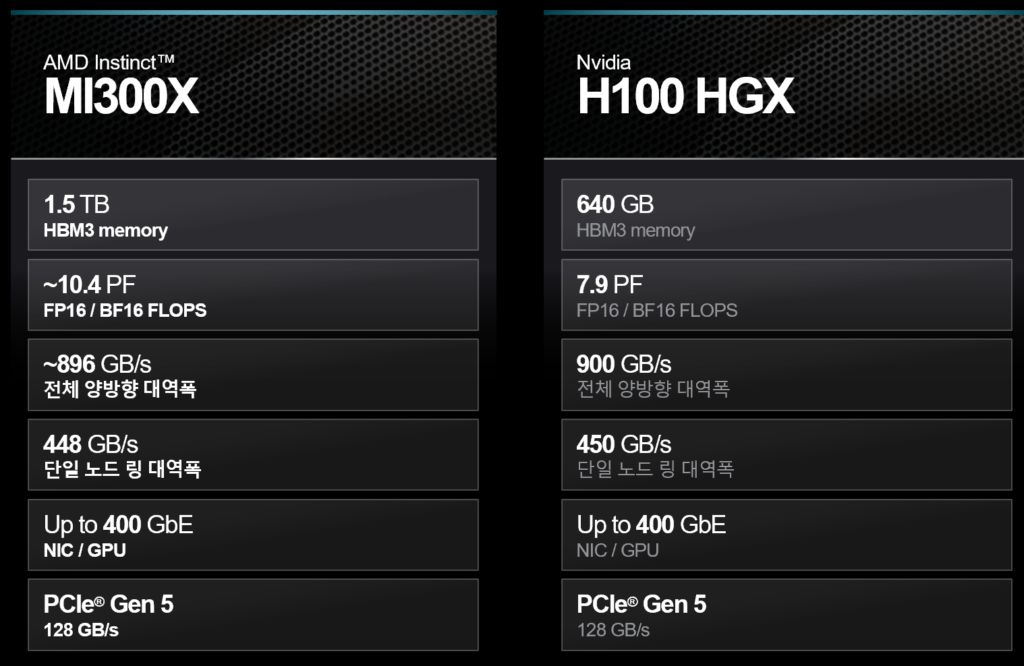

3. 메모리 및 대역폭

- NVIDIA H100:

- 메모리: 80 GB HBM2e(PCIe/SXM), 94 GB HBM2e(PCIe)

- 대역폭: 약 3.2 TB/s

- NVIDIA H200:

- 메모리: 141 GB HBM3

- 대역폭: 약 3.2 TB/s

- AMD MI300X:

- 메모리: 최대 192 GB HBM3 (NVIDIA의 H100 및 H200보다 더 큼)

- 대역폭: 약 5 TB/s로, 대형 AI/ML 모델에서 중요한 빠른 데이터 접근과 전송을 지원합니다.

4. 확장성 및 응용 분야

- NVIDIA H100/H200:

- AI 학습 클러스터와 대규모 슈퍼컴퓨팅 환경에서 널리 사용됩니다.

- 텐서 코어와 NVIDIA 소프트웨어 생태계(CUDA, cuDNN 등)는 AI, 딥러닝, 과학 계산에 최적화되어 있습니다.

- H200은 더 효율적인 메모리 활용으로 대형 LLM과 차세대 AI 모델을 목표로 합니다.

- AMD MI300X:

- 대형 AI/ML 워크로드, 클라우드 데이터 센터, HPC를 타겟으로 합니다.

- CPU+GPU 통합 아키텍처로 혼합 워크로드 실행에 더 많은 유연성을 제공하여 AI 추론에 적합합니다.

5. 전력 효율성

- NVIDIA H100/H200:

- 300-700W 사이의 전력을 소모하며, H200은 메모리 용량 증가로 약간 높은 전력소모율을 보여줄 것으로 예상됩니다.

- AMD MI300X:

- 비슷한 전력 소모를 가지며, 통합된 컴퓨팅과 메모리로 인해 특정 환경에서 더 높은 시스템 효율성을 제공할 수 있습니다.

6. 소프트웨어 생태계

- NVIDIA H100/H200:

- CUDA, cuDNN, TensorRT와 같은 NVIDIA의 강력한 소프트웨어 지원을 받으며, TensorFlow와 PyTorch와 같은 AI/ML 프레임워크와 잘 통합되어 있습니다.

- AMD MI300X:

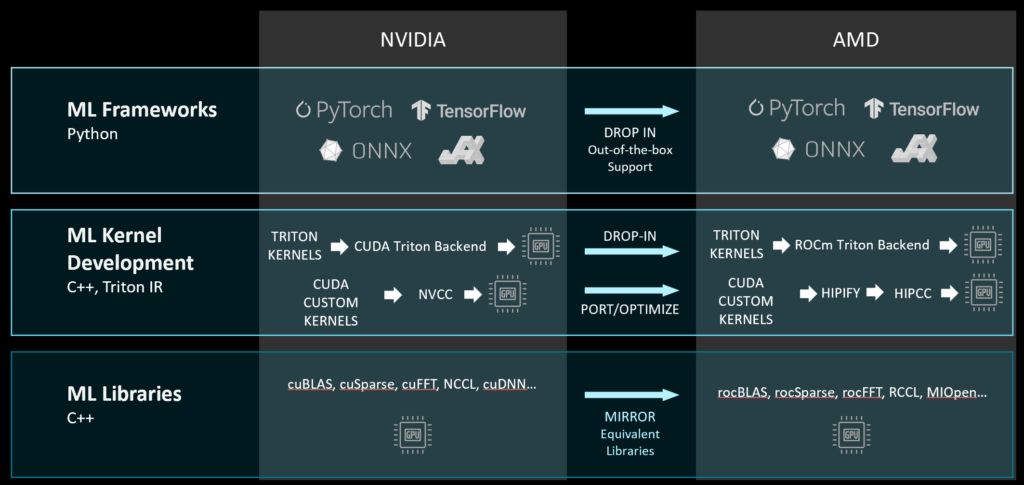

- AMD ROCm 기반의 개발환경이 지속적으로 준비 중이지만, 소프트웨어의 성숙도와 개발자 선택 면에서는 NVIDIA가 다소 앞서고 있습니다.

- ROCm (Radeon Open Compute) 생태계

– ROCm은 AMD의 주요 오픈 소스 소프트웨어 플랫폼으로, 고성능 컴퓨팅 및 머신러닝 워크로드를 지원하기 위해 설계되었습니다. ROCm은 MI300X와 같은 GPU에서 효율적인 계산을 수행할 수 있도록 다양한 라이브러리와 도구를 제공합니다.

– ROCm에는 AI 및 머신러닝 작업에 필요한 다양한 라이브러리(TensorFlow, PyTorch, ONNX Runtime 등)가 최적화되어 있어 MI300X에서 원활하게 실행될 수 있습니다. - HIP (Heterogeneous-Compute Interface for Portability):

– CUDA와 호환 가능한 인터페이스로, 기존의 CUDA 코드를 쉽게 포팅하여 AMD GPU에서 실행할 수 있습니다. 이는 기존 NVIDIA 환경에서 AMD로 전환을 돕는 중요한 기능입니다. - AI 및 HPC 라이브러리 지원

– AMD는 MI300X를 AI 모델 훈련 및 추론에 최적화하기 위해 ROCm 생태계 내의 다양한 라이브러리 지원을 강화하고 있습니다. TensorFlow, PyTorch, ONNX 등 주요 AI 프레임워크가 MI300X를 지원하도록 ROCm에서 최적화를 진행 중입니다.

– MI300X의 HBM3 메모리와 CDNA 3 아키텍처의 성능을 극대화할 수 있도록 메모리 관리와 데이터 병목을 줄이는 작업이 포함된 라이브러리들이 지속적으로 업데이트되고 있습니다. - MI300X 최적화를 위한 소프트웨어 도구

– MI300X는 GPU와 CPU가 통합된 APU(Accelerated Processing Unit) 아키텍처로, 이종 연산에 적합합니다. 이를 위해 AMD는 소프트웨어 개발자들이 CPU와 GPU 자원을 효율적으로 활용할 수 있는 도구들을 제공하고 있습니다

– 이를 통해 대규모 데이터셋을 다루는 AI/ML 작업에서 CPU와 GPU 간의 작업 분배를 최적화하여 성능을 극대화할 수 있습니다.

| NVIDIA | AMD | |

| Math Libraries | CuBLAS | rocBLAS |

| CuBLASLt | hipBLASLt | |

| cuFFT | rocFFT | |

| cuSOLVER | rocSOLVER | |

| cuSPARSE | rocSPARSE | |

| cuRAND | rocRAND | |

| Communication Library | NCCL | RCCL |

| C++ Core Library | Thrust | rocThrust |

| CUB | hipCUB | |

| Wave Matrix Multiply Accumulate Library | WMMA | rocWMMA |

| Deep Learning / Machine Learning primitives | cuDNN | MIOpen |

| C++ templates abstraction for GEMMs | CUTLASS | Composable Kernel |

요약:

- NVIDIA H100: AI 중심 작업에서 최적의 선택으로,그동안 개발된 NVIDIA 기반의 어플리케이션 사용도가 중요한 경우에 선택됩니다.

- NVIDIA H200: H100 GPU 대비 메모리 용량이 향상되었으므로, 대규모 LLM 등 AI 워크로드에서 더 높은 성능과 효율성을 제공합니다.

- AMD MI300X: 엄청한 용량의 메모리와 대역폭으로 대형 데이터 접근이 중요한 모델과 CPU+GPU 통합 컴퓨팅이 필요한 환경에 적합하며

특히 과학기술연산에서 요구되는 64bit 연산(FP64) 성능구현에 탁월한 장점을 지니고 있습니다.