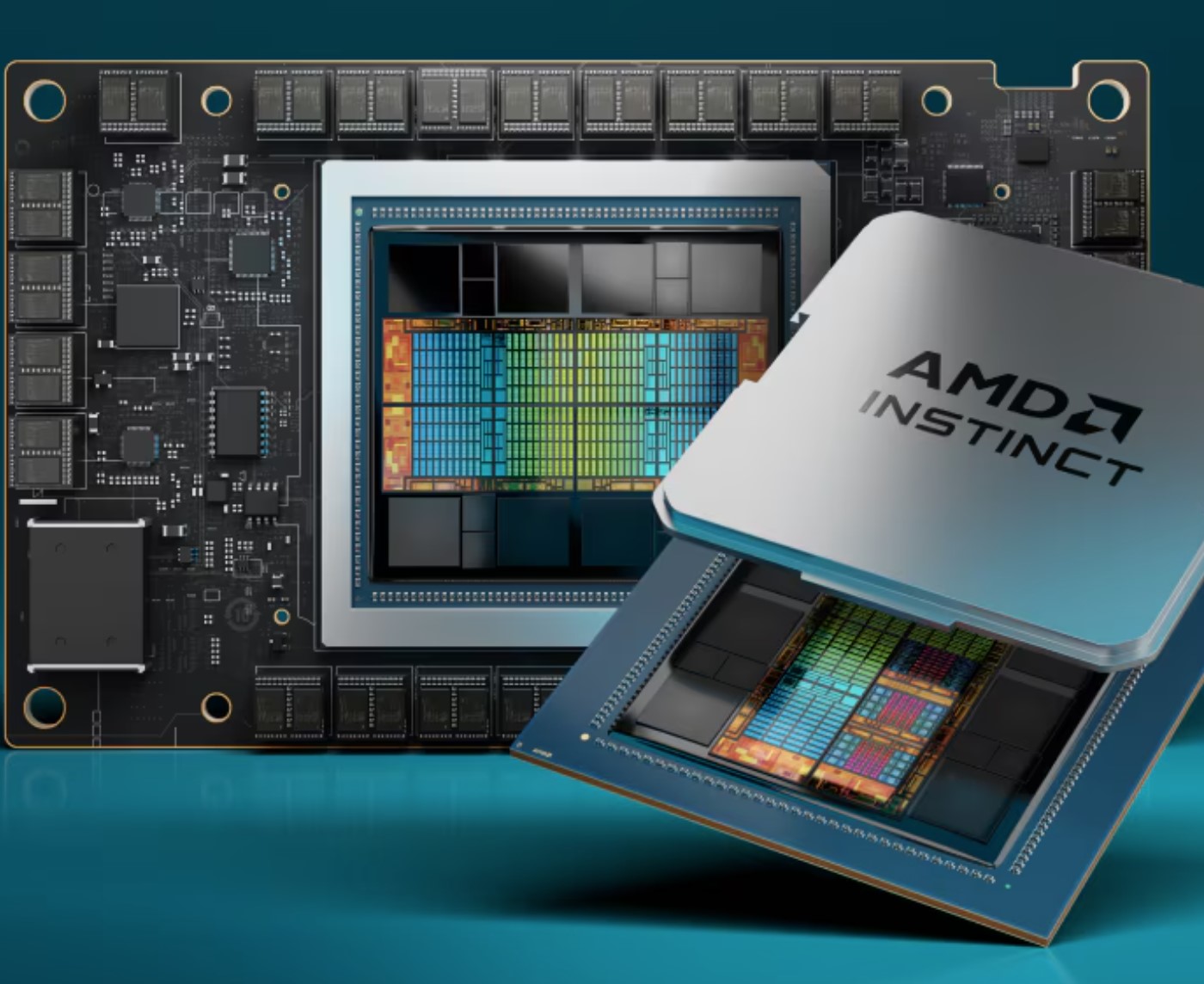

AMD의 AI 목적 GPU 라인업은 특히 MI200 시리즈와 MI300 시리즈로 잘 알려져 있으며, AI 및 고성능 컴퓨팅(HPC) 작업에 최적화되어 있습니다. 주요 GPU와 OAM(Open Accelerator Module) 아키텍처에 대한 요약과 주요 사용 사례를 설명하겠습니다.

1. AMD Instinct MI300 시리즈 (MI300X 및 MI300A)

- MI300X:

- 목적: 대규모 AI 추론 및 훈련을 위한 메모리 중심의 GPU로, 대형 언어 모델(LLM), 생성 AI, 데이터 집약적인 AI 애플리케이션에 최적화되어 있습니다.

- 아키텍처: CPU 및 GPU 코어를 결합한 하이브리드 아키텍처를 기반으로 합니다. MI300X는 192 GB의 HBM3 메모리를 갖추고 있어 대규모 데이터셋과 딥러닝 모델에 적합합니다.

- OAM 아키텍처: MI300X는 대규모 AI 및 HPC 시스템에 효율적으로 다중 GPU를 구성할 수 있도록 OAM 표준을 사용합니다.

- 성능: FP16에서 최대 153 TFLOPS, INT8에서 최대 307 TFLOPS의 성능을 제공합니다. 메모리 용량과 대역폭이 복잡한 AI 모델에 큰 이점이 됩니다.

- MI300A:

- 목적: 24개의 Zen 4 CPU 코어와 CDNA 3 GPU 아키텍처를 결합한 하이브리드 APU로, 128 GB의 HBM3 메모리를 갖추고 있습니다. AI 작업과 일반적인 HPC 작업을 모두 처리할 수 있도록 설계되었습니다.

- 통합성: 이 APU는 엑사스케일 컴퓨팅을 목표로 하며, CPU-GPU 통합이 필요한 시스템에 적합합니다.

2. AMD Instinct MI200 시리즈 (MI250 / MI250X)

- MI250 및 MI250X:

- 목적: AI와 HPC 작업 모두에 최적화된 MI250 시리즈는 MI300 이전 AMD의 대표적인 GPU였습니다. 듀얼 GPU 아키텍처로 대규모 병렬 처리를 지원합니다.

- 아키텍처: CDNA 2 아키텍처를 기반으로 하며, 최대 128 GB의 HBM2e 메모리를 갖추고 있습니다. 메모리 중심 작업에 적합해 딥러닝, 과학 시뮬레이션, 빅데이터 분석 등에 사용됩니다.

- OAM 아키텍처: MI200 시리즈도 OAM을 사용해 대규모 AI 클러스터에서 유연한 확장이 가능합니다.

- 성능: MI250X는 FP16에서 최대 95.7 TFLOPS, INT4에서 최대 383 TOPS의 성능을 제공합니다.

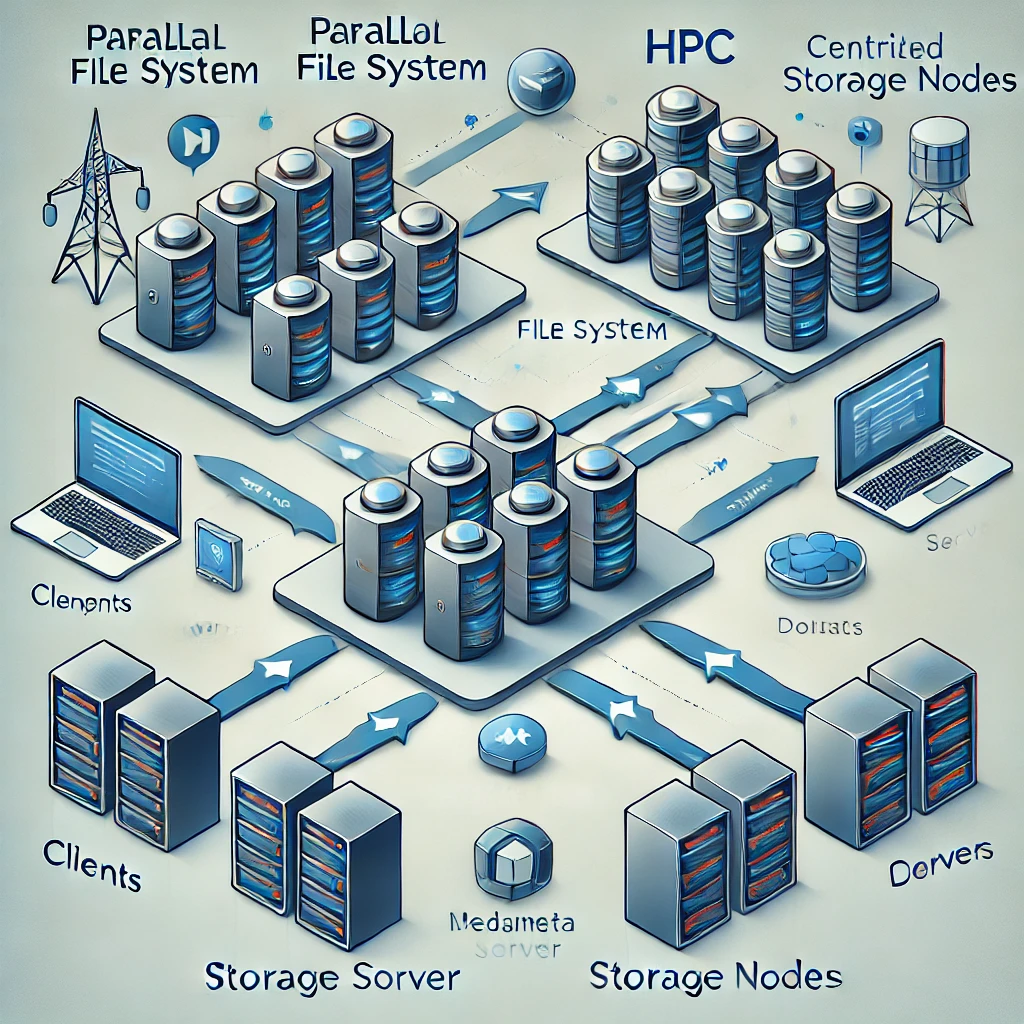

3. OAM (Open Accelerator Module) 아키텍처 (Infinity Platform)

- AMD의 Instinct MI200 및 MI300 시리즈는 대규모 HPC와 AI 애플리케이션을 지원하기 위해 설계된 OAM 폼 팩터를 사용합니다. OAM 아키텍처는 여러 GPU를 상호 연결해 확장성을 높이고 대량의 데이터 대역폭을 지원합니다.

AMD MI200 및 MI300 GPU를 사용하는 주요 시스템 및 참조 사례

1. Frontier Supercomputer / WW #1 AI Supercomputer

- 위치: Oak Ridge National Laboratory (ORNL), 미국

- 구축 연도: 2022년

- 사용된 GPU: AMD Instinct MI250X

- CPU: AMD EPYC 3세대 프로세서 (코드명: Milan)

- 시스템 성능:

- 최대 성능: 1.1 엑사플롭스 (exaFLOPS)

- 이론적 성능: 1.69 엑사플롭스

- GPU 성능: MI250X는 각각 최대 383 TOPS (INT4) 성능 제공

- 용도: Frontier는 과학적 발견을 위한 엑사스케일 컴퓨팅 연구, 기후 변화 모델링, 신약 개발, 물리학 연구, AI 및 머신러닝 모델 훈련에 사용됩니다.

- 특징: Frontier는 세계 최초로 엑사스케일 성능을 달성한 슈퍼컴퓨터로, 2022년 TOP500 리스트에서 1위를 기록했습니다. 이 시스템은 AMD의 CDNA 2 아키텍처 기반 GPU와 높은 메모리 대역폭을 활용해 복잡한 계산을 지원합니다.

2. LUMI Supercomputer) / WW #5 AI Supercomputer

- 위치: CSC 데이터 센터, 카야니, 핀란드

- 구축 연도: 2021년

- 사용된 GPU: AMD Instinct MI250

- CPU: AMD EPYC 3세대 프로세서

- 시스템 성능:

- 최대 성능: 375 페타플롭스 (petaFLOPS)

- GPU 성능: MI250 GPU는 95.7 TFLOPS (FP16) 성능 제공

- 용도: AI 연구, 기후 모델링, 분자 시뮬레이션, 생명과학 연구 등 다양한 과학적 연구 및 빅데이터 애플리케이션에 활용됩니다.

- 특징: 루미는 유럽에서 가장 강력한 슈퍼컴퓨터 중 하나로, 에너지 효율을 고려해 설계되었습니다. MI250 GPU의 병렬 처리 성능과 HBM2e 메모리 대역폭을 활용해 대규모 데이터셋과 복잡한 계산 작업을 지원합니다.

3. El Capitan Supercomputer / WW #0 AI Supercomputer (2024)

- 위치: Lawrence Livermore National Laboratory (LLNL), 미국

- 예정 구축 연도: 2024년

- 사용될 GPU: AMD Instinct MI300 (MI300A와 MI300X 조합)

- CPU: AMD EPYC 4세대 프로세서 (Zen 4)

- 예상 성능:

- 최대 성능: 2 엑사플롭스 (exaFLOPS)

- GPU 성능: MI300X는 최대 153 TFLOPS (FP16) 성능 제공

- 용도: 국가 안보 시뮬레이션, 생명과학 연구, 데이터 분석, AI 기반 연구 등 고급 시뮬레이션과 분석 작업을 처리할 예정입니다.

- 특징: 엘 카피탄은 AMD의 최신 하이브리드 APU 아키텍처와 OAM을 활용해 CPU와 GPU 간 통합 성능을 극대화합니다. 이 시스템은 더욱 복잡하고 정밀한 시뮬레이션을 가능하게 할 것입니다.

요약

이들 슈퍼컴퓨터는 AI와 HPC 성능에서 중요한 전환점을 보여줍니다. 특히 Frontier와 El Capitan은 엑사스케일 컴퓨팅의 새로운 기준을 설정하며, AMD의 MI250 및 MI300 GPU의 성능과 확장성을 잘 활용하고 있습니다. MI300 시리즈는 하이브리드 CPU-GPU 아키텍처로 새로운 성능 한계를 제시하며, 대규모 AI 모델 훈련과 데이터 분석 작업에 필수적인 요소로 자리잡고 있습니다. AMD의 MI200 및 MI300 시리즈는 AI 및 HPC 성능에서 중요한 발전을 이뤘으며, 특히 대규모 배포를 위해 OAM 아키텍처를 채택했습니다.

AMD AI GPU가 NVIDIA보다 추천되는 이유는 다음과 같은 성능, 비용, 오픈 소스 호환성, AI 워크로드에 대한 유연성 때문입니다. 아래는 AMD GPU가 선호되는 이유와 애플리케이션 호환성 및 포팅 지원에 대한 상세 내용입니다.

1. 오픈 에코시스템 및 ROCm 지원

- AMD의 ROCm(Radeon Open Compute) 플랫폼은 오픈 소스 소프트웨어 스택으로, 특히 연구 및 커스텀 AI 프로젝트에서 개발자들에게 유연성을 제공합니다. NVIDIA의 CUDA는 독점적인 반면, ROCm은 오픈 표준을 지원하며 이러한 프로젝트에서 큰 장점을 제공합니다.

- ROCm은 TensorFlow, PyTorch, ONNX와 같은 인기 있는 AI 프레임워크와의 호환성을 제공하여, NVIDIA의 CUDA로 개발된 모델을 비교적 쉽게 포팅할 수 있습니다.

2. 비용 효율성

- AMD AI GPU는 NVIDIA 대비 더 나은 가격 대비 성능비를 제공하는 경우가 많아 대규모 배포에서 비용이 중요한 요소일 때 매력적인 선택입니다.

- 특히 데이터 센터 및 HPC(고성능 컴퓨팅) 시장에서, AMD의 MI200 및 MI300 시리즈는 성능 면에서 경쟁력이 있으며 비용 절감 효과도 큽니다.

3. 대용량 모델에 대한 메모리 대역폭 및 성능

- AMD GPU, 특히 최신 시리즈는 높은 메모리 대역폭을 제공하며, 이는 대규모 AI 모델을 효율적으로 학습시키는 데 필수적입니다. 예를 들어, Instinct MI250 및 MI300 시리즈는 고대역폭 메모리(HBM2)를 탑재하고 있으며, 대규모 모델 학습에서 뛰어난 성능을 발휘합니다.

4. 확장성 및 인터커넥트 지원

- AMD GPU는 멀티-GPU 설정에서 잘 확장되며, 특히 대규모 AI 클러스터에서 필요한 확장성을 제공합니다. AMD의 Infinity Fabric과 같은 고급 인터커넥트 기술은 이러한 확장성을 더욱 강화합니다.

5. 이종 환경에서의 더 나은 호환성

- 다양한 벤더의 CPU, 가속기 및 GPU가 혼재된 환경에서 AMD GPU는 더 넓은 범위의 하드웨어와의 호환성을 제공합니다. AMD는 x86과 ARM 기반 아키텍처 모두를 지원하기 때문에 이러한 유연성이 더욱 강조됩니다.

6. 애플리케이션 포팅 및 생태계 지원

- CUDA가 AI 분야에서 지배적이었지만, AMD는 ROCm을 통해 생태계 지원을 확대해 왔습니다. 많은 AI 라이브러리와 프레임워크가 이제 ROCm을 네이티브로 지원하여 NVIDIA 하드웨어에서 AMD 하드웨어로의 전환을 용이하게 합니다.

- 하드웨어 종속성을 다양화하거나 벤더 락인에서 벗어나려는 기업 및 조직에게 AMD의 생태계는 점점 더 매력적이 되고 있습니다.

7. 협업 및 산업 채택

- AMD는 클라우드 제공업체 및 연구 기관과의 파트너십을 통해 소프트웨어 생태계 지원을 넓혀가고 있습니다. 최적화된 라이브러리, 개선된 ROCm 도구, 주요 클라우드 플랫폼과의 통합 등으로 AMD GPU에서 AI 모델을 배포하는 것이 점점 더 쉬워지고 있습니다.

애플리케이션 호환성 및 포팅 지원

- 프레임워크 지원: TensorFlow, PyTorch, ONNX와 같은 인기 있는 프레임워크는 ROCm을 통해 AMD GPU를 지원합니다. AMD는 이러한 프레임워크의 성능을 최적화하기 위해 지속적으로 노력하고 있습니다.

- 모델 포팅: ROCm을 사용하면 CUDA로 설계된 모델을 AMD GPU에서 실행할 수 있도록 코드 변경을 최소화할 수 있습니다. ROCm은 많은 CUDA API를 지원하여 전환을 쉽게 만듭니다.

- Docker 및 Kubernetes: ROCm은 Docker 및 Kubernetes와 통합되어 있어 컨테이너화된 환경에서 AI 워크로드를 배포하는 것이 간단합니다.

NVIDIA는 여전히 AI 분야에서 강력한 지위를 가지고 있지만, 특정 상황에서는 AMD GPU가 더 나은 대안으로 점점 더 인식되고 있습니다. 오픈 소스 생태계 지원, 비용 효율성, 높은 메모리 대역폭, 뛰어난 확장성 등은 AMD GPU를 매력적으로 만들며, 특히 오픈 표준을 우선시하고 유연하고 확장 가능한 솔루션을 찾는 조직에게 적합합니다. 애플리케이션 호환성도 계속 개선되고 있어 AMD 하드웨어로의 전환이 시간이 지남에 따라 점점 더 원활해지고 있습니다.